ベイズの定理とは,条件付き確率に関する等式

P(A\mid B) = \frac{P(B\mid A) P(A)}{P(B)}

を指します。これについて,その証明と,意義も含めた応用例を紹介しましょう。

ベイズの定理とその証明

B が起こったもとで A が起こるという「条件付き確率」は,

P(A\mid B) = \frac{P(A\cap B)}{P(B)}

と定義されましたね。 P_B(A) とかくこともあると思います。これに関する等式が,ベイズの定理です。

定理(ベイズの定理;Bayes’ theorem)

A,B を事象とし, P(B)>0 とする。このとき,条件付き確率について

\color{red}P(A\mid B) = \frac{P(B\mid A) P(A)}{P(B)}

である。

先に証明をチェックしましょう。

証明

条件付き確率の定義より,

\!\!\! P(A\mid B)P(B)=P(A\cap B) = P(B\mid A)P(A)

であり,両端辺 P(B) で割ると結論を得る。

証明終

証明をみればわかるように「ベイズの定理」自体は非常に簡単な話を仰々しく言ったに過ぎません。しかし,この定理は非常に有用です。紹介しましょう。

ベイズの定理の有用性

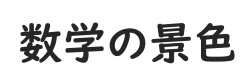

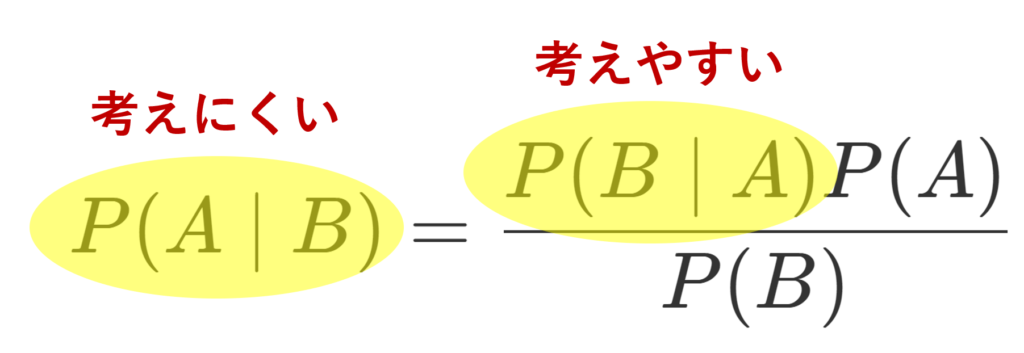

ベイズの定理において,左辺には条件付き確率 P(A\mid B) 右辺には P(B\mid A) がありますから,この等式は, P(A\mid B) を, P(B\mid A) を用いて求めようという形になっていますね。

P(A\mid B) よりも P(B\mid A) の方が考えるのが簡単だったとしましょう。たとえば,引いたくじを戻さないくじ引きにおいて,

A:一人目が当たる事象

B : 二人目が当たる事象

とします。このとき,

P(A\mid B) :二人目が当たったとき,一人目も当たった確率

P(B\mid A):一人目が当たったとき,二人目も当たる確率

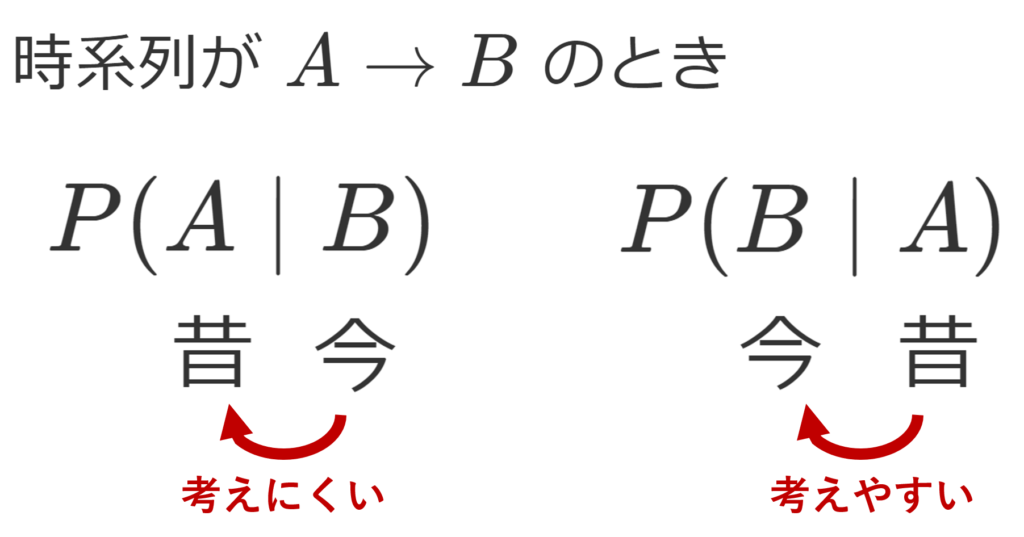

となって, P(A\mid B) よりも P(B\mid A) の方が考えやすいですね。このような例のように,時系列が A\to B のときは, P(A\mid B) より P(B\mid A) の方が考えやすいことが多いです。前者は時系列が逆転していて,後者はそのままですから,何となく理解できるでしょう。

このようなときは,ベイズの定理が使えるというわけです。

実際,5本中2本があたりのくじ引きなら,くじの原則により, P(A)=P(B)=2/5 で,さらに P(B\mid A)= 1/4 ですから,

P(A\mid B)=\frac{1/4\times 2/5}{2/5}=\frac{1}{4}

と,ベイズの定理を使って求められますね。

ベイズの定理は,病気の判定にも用いられています。たとえば,

A:病気を実際に患っている事象

B : 検査で陽性になる事象

としましょう。このとき,

P(A\mid B) :検査で陽性のとき,実際に病気である確率

P(B\mid A):実際に病気のとき,検査で陽性になる確率

となります。患者が知りたいのは P(A\mid B) ですが,病気の検査キッドの精度指標としては, P(B\mid A) が計算しやすいですから,このような場合も,ベイズの定理が使えるというわけです。

他にも,「迷惑メール」の検知にも用いられています。実際に知りたいのは,「ある特徴があるメールが迷惑メールかどうか」ですが,統計的にわかりやすいのは,「迷惑メールにはどういう特徴があるか」の方だからです。

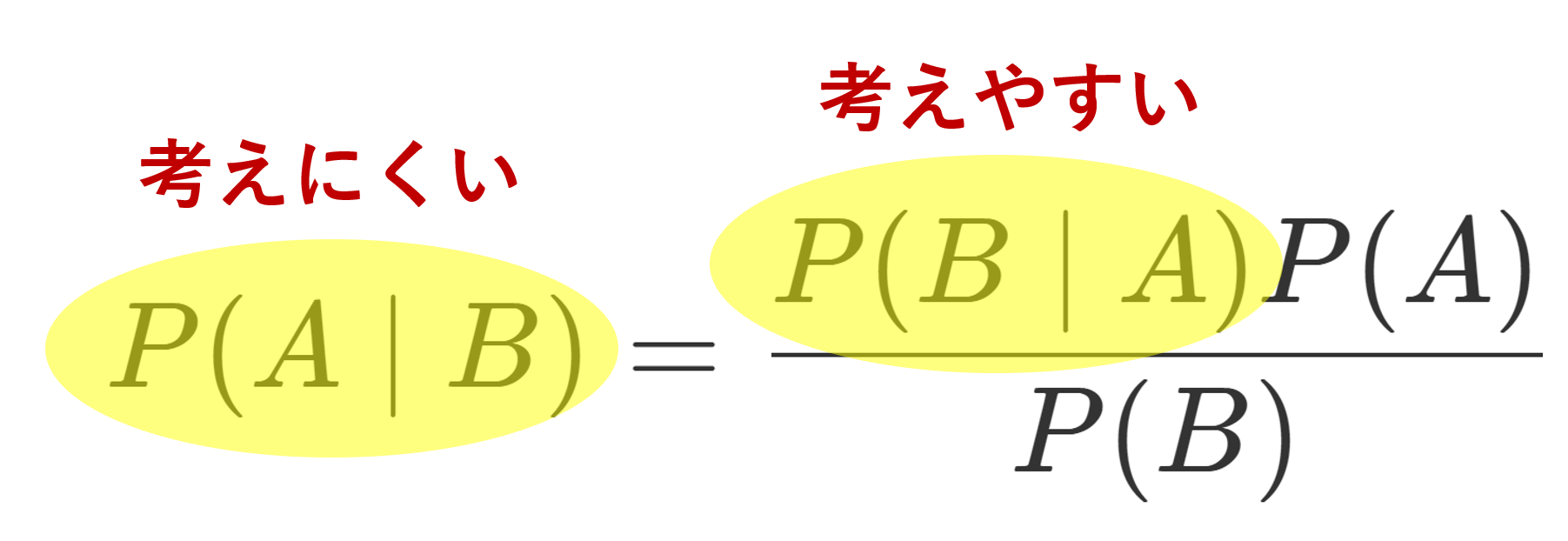

ベイズの定理からベイズ統計学へ

本定理を道具として用いつつ,統計学を展開するのに,ベイズ統計学 (Bayesian statistics) というのがあります。

これはざっくりいうと,A の確率 P(A) をできるだけ正確に推定したいときに,とりあえず P(A) を適当に仮定し,そこから周辺情報 B を手掛かりにして,計算しやすい P(B\mid A) を考えることで, P(A\mid B) を求め,これにより,「 A の確率の正確性が上がった」と思う統計学です。

たとえば,事件において,犯人が〇〇である確率を適当に推察し,そこから状況証拠をもとに,〇〇が犯人である確率をアップデートしていくような感じです。

ちょっと意味不明かもしれませんが,詳しくは別の機会で解説しましょう。